开坑,刚看完书,已经有些窒息了

先把坑挖了,再慢慢填,避免自己划水跳过

我爱线代,线代爱我,阿弥陀佛

为什么要学奇异值分解?

因为书本倒数第二章专门提到的,想必一定很重要,于是我上网查了一下奇异值分解的应用

wow 。。。很有用,增加了学习的动力

在机器学习中,奇异值分解,可以删除一些没什么作用的特征。

具体是如何删除的呢?需要先了解一下,奇异值分解的数学原理

不会吧。。。我难道要用markdown语法来写矩阵的推导过程吗。。。

太痛苦了吧

首先,奇异值是什么?分解又从何谈起?

- 奇异值分解的本质,其实是矩阵分解的延伸

什么是矩阵分解?矩阵分解又有什么意义呢?

- 矩阵分解,是将一个矩阵分解为多个形式简单的矩阵,可以更好地理解矩阵本身的作用

-

感觉像一句废话,举个栗子吧…oh不,举个up主:矩阵分解及正交矩阵

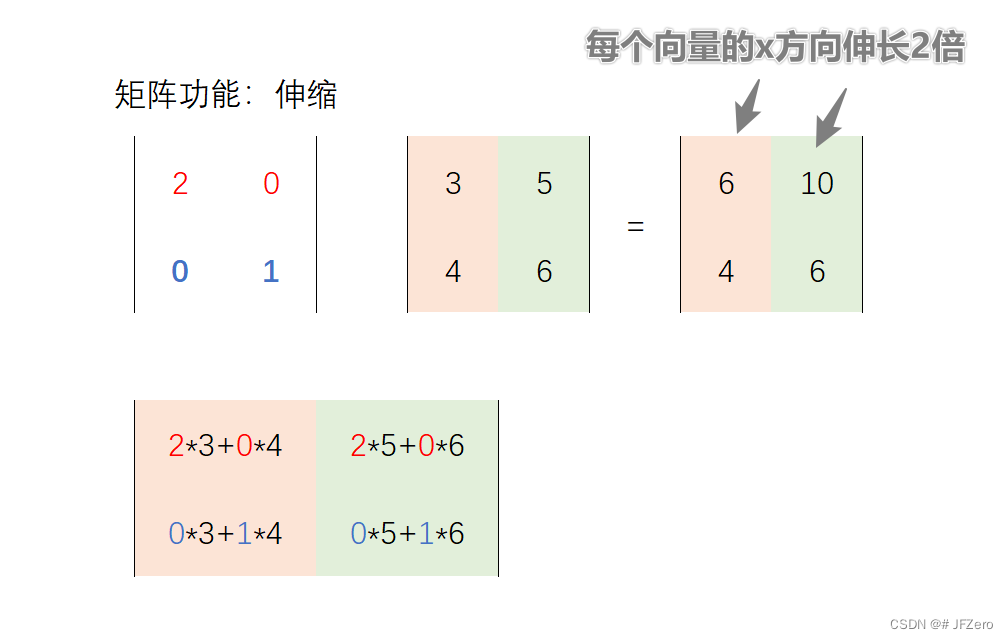

- 其实就是用矩阵的伸缩、旋转变换功能来举例

向量

向量一般是竖着写的

向量的代数表示

向量一般用于表示一个多元齐次方程的系数

- a 1 x 1 + a 1 x 1 + a 1 x 1 = 0 a_1x_1+a_1x_1+a_1x_1=0 a1x1+a1x1+a1x1=0

那么这个多元齐次方程的系数,可以用向量 A → A^→ A→表示

A = [ a 1 a 2 a 3 ] \begin{bmatrix} a_1\\ a_2\\ a_3\\ \end{bmatrix} a1a2a3

向量的几何表示

向量的维数:

-

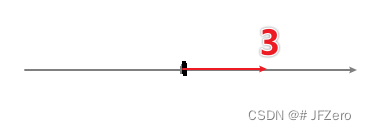

一维向量表示直线上的方向向量

-

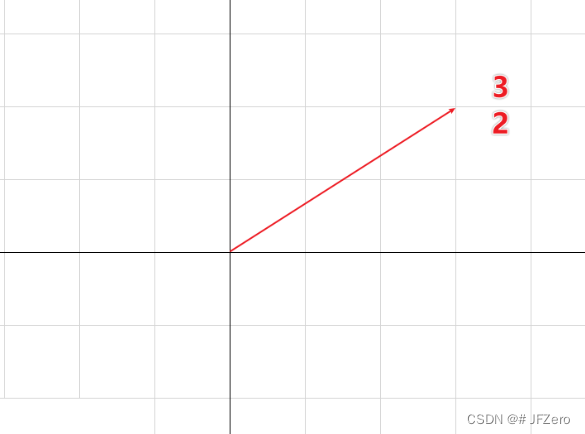

二维向量表示平面上的方向向量,如 [ 3 2 ] \begin{bmatrix} 3\\ 2\\ \end{bmatrix} [32]

-

三维向量表示空间上的方向向量 [ 0 1 1 ] \begin{bmatrix} 0\\ 1\\ 1\\ \end{bmatrix} 011

哭了,用上matplotlib吧

向量的乘法

向量乘法,一般指的是点乘,即

A =

[

a

1

a

2

a

3

]

\begin{bmatrix} a_1\\ a_2\\ a_3\\ \end{bmatrix}

a1a2a3

,B =

[

b

1

b

2

b

3

]

\begin{bmatrix} b_1\\ b_2\\ b_3\\ \end{bmatrix}

b1b2b3

,则

A

B

=

a

1

∗

b

1

+

a

2

∗

b

2

+

a

3

∗

b

3

AB = a_1*b_1+ a_2*b_2+ a_3*b_3

AB=a1∗b1+a2∗b2+a3∗b3

向量点乘的代数意义

待思考!!!!!

向量点乘的几何意义

向量与矩阵的关系

矩阵的乘法

矩阵乘法的功能:伸缩

矩阵乘法功能:旋转

矩阵乘法功能:伸缩+旋转

首先,任何矩阵,都可以进行奇异值分解

M

=

U

Σ

V

T

,

其中,

U

和

V

都是对称矩阵,

Σ

是正交对角阵

M = UΣV^T,其中,U和V都是对称矩阵,Σ是正交对角阵

M=UΣVT,其中,U和V都是对称矩阵,Σ是正交对角阵